在数字化浪潮的推动下,文件安全正面临前所未有的复杂挑战。传统的外部攻击已不再是唯一威胁,内部人员风险、日益精密的恶意软件,尤其是人工智能(AI)技术的双重作用——既作为防御工具也作为攻击武器——正在深度融合,形成一个危险的“三重威胁”矩阵,显著推高了文件安全风险,特别是在人工智能基础软件开发这一关键领域。

一、 内部人员威胁:从疏忽到恶意

内部人员始终是信息安全链条中最不可预测的一环。在AI开发环境中,这种风险被进一步放大:

- 无意的疏忽:开发人员可能因配置错误、将敏感代码或训练数据上传至公共仓库(如GitHub),或在测试环境中使用真实数据,导致核心算法模型、专有数据集或机密设计文档无意中暴露。

- 有意的窃取:掌握核心算法、模型架构或关键数据的员工、研究员或合作伙伴,可能出于经济利益、商业竞争或不满情绪,窃取知识产权。AI模型本身作为一种高度浓缩的知识资产,其窃取行为更具隐蔽性和破坏性。

二、 恶意软件的进化:瞄准AI资产

现代恶意软件已将其触角伸向AI开发流程:

- 供应链攻击:攻击者污染AI开发所依赖的开源库(如PyTorch、TensorFlow的第三方插件)、框架或训练数据集。一旦被下载和使用,恶意代码便可嵌入模型或应用中,形成持久后门。

- 数据投毒:通过在训练数据中注入精心构造的恶意样本,攻击者可以“教坏”AI模型,使其在特定场景下产生错误或带有偏见的输出,破坏模型的完整性与可靠性。

- 模型窃取与逆向工程:通过API查询攻击等方式,恶意软件可协助攻击者窃取或逆向还原黑盒AI模型的功能与参数,复制知识产权。

三、 人工智能的双刃剑效应

AI技术本身正在重塑攻防格局:

- AI赋能的攻击:攻击者利用AI生成高度逼真的钓鱼邮件(如利用大语言模型)、绕过传统检测系统的自适应恶意软件、自动化漏洞挖掘工具,以及对文件进行深度伪造,使得基于签名或简单规则的安全防御体系日益乏力。针对AI开发流程,攻击性AI可以更高效地寻找代码漏洞或设计攻击路径。

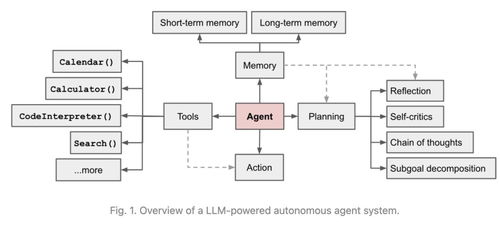

- AI驱动的防御:与此AI也是强大的安全盾牌。通过机器学习模型分析用户行为(UEBA)、检测异常数据访问模式、识别恶意代码变种,AI能够提供更主动、智能的文件安全防护,特别是在海量日志和复杂行为中发现内部威胁的蛛丝马迹。

四、 对AI基础软件开发的特殊冲击

AI基础软件开发(包括算法研究、模型训练、框架开发)因其特性,成为风险汇聚的高地:

- 资产价值极高:模型、算法、数据是核心竞争力,一旦泄露,损失难以估量。

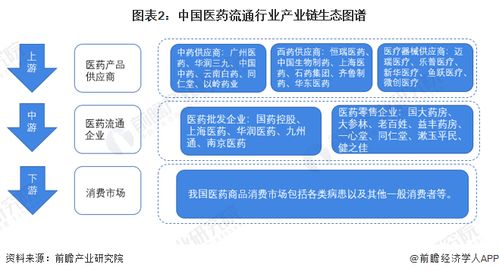

- 协作环境复杂:涉及多团队、多工具链、云端与本地混合环境,数据流转频繁,攻击面广。

- 对数据的高度依赖:训练数据的质量与安全性直接决定模型的安全性,数据环节成为关键攻击点。

- 技术门槛高:安全团队可能难以完全理解AI开发流程中的独特风险,导致防护措施脱节。

五、 构建融合防御体系

应对这一融合性威胁,需要超越传统边界的综合性策略:

- 零信任架构贯彻:对内部人员和外部的访问一视同仁,实施最小权限原则,对所有访问AI资产、代码库、数据存储的行为进行持续验证和严格授权。

- 全生命周期数据与模型安全:从数据采集、标注、训练到模型部署、推理,每个环节都需加密、脱敏、完整性校验及访问审计。采用模型水印、加密推理等技术保护模型知识产权。

- 行为分析与智能监控:利用AI技术本身,建立针对开发人员、数据科学家行为基线的监控系统,实时检测异常的数据下载、代码访问、模型导出等操作。

- 供应链安全强化:严格管理第三方依赖,对开源组件进行安全扫描与验证,建立安全的内部镜像和仓库。

- 安全意识与专项培训:针对AI研发人员开展专项安全培训,使其明确自身在保护关键数字资产中的责任,识别社会工程学攻击和操作风险。

###

内部人员、进化型恶意软件与人工智能挑战的融合,并非简单的风险叠加,而是产生了“1+1+1>3”的乘数效应,正在重新定义文件安全的战场。对于处于创新前沿的AI基础软件开发而言,这既是严峻的挑战,也是推动安全范式升级的契机。唯有通过技术、管理与文化的深度融合,构建适应AI时代的新型动态防御体系,才能在享受AI红利的筑牢文件与知识资产的最后防线。